Echtzeit-Analytics: Computer Vision im Eishockey

Blogbeitrag vom 28. September 2025

von Kevin Lancashire (Link zum Original-Text auf Englisch)

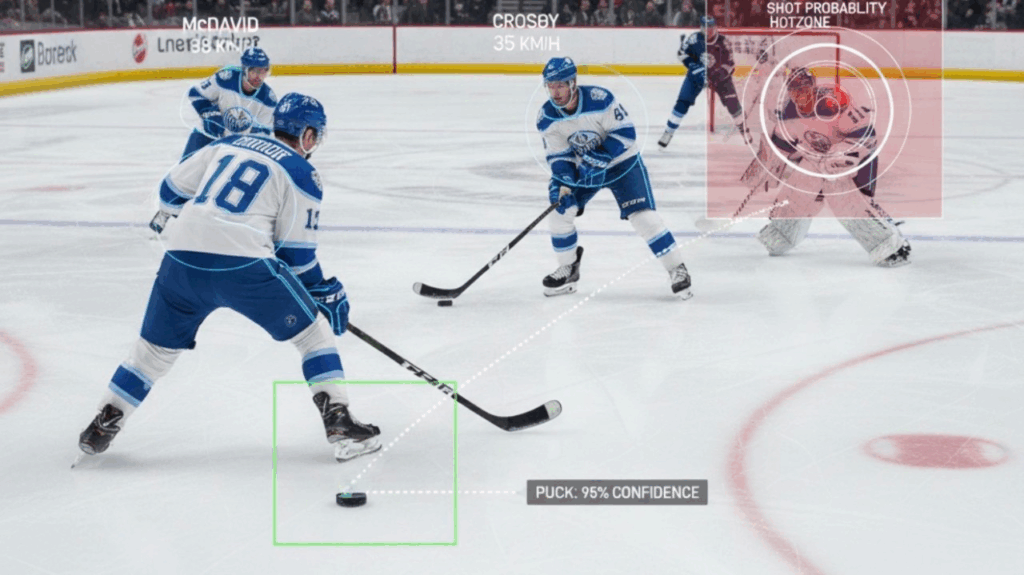

Computer Vision im Eishockey bezeichnet den Einsatz fortschrittlicher Technologien zur Analyse und Interpretation der Spieldynamik anhand visueller Daten. Diese innovative Anwendung hat in den letzten Jahren an Bedeutung gewonnen, da Teams und Analysten ausgefeilte Algorithmen nutzen, um die Spielerverfolgung, Leistungsanalyse und Spielstrategien zu verbessern. Die Integration von Computer Vision hat die traditionellen Methoden der Spielerbewertung und Strategieformulierung revolutioniert und einen bedeutenden Wandel hin zu datengestützten Entscheidungen in diesem Sport bewirkt. Bemerkenswerte Beiträge von Unternehmen wie Sportlogiq haben das Potenzial der Computer Vision unterstrichen, bisher nicht wahrnehmbare Erkenntnisse zu liefern, von denen Teams in der National Hockey League (NHL) und darüber hinaus profitieren.

Die Entwicklung der Computer Vision im Eishockey lässt sich bis in die späten 1990er Jahre zurückverfolgen, als die Einführung von Datenbanken wie RinkNet begann, die Landschaft der Spieleranalyse zu verändern. Angesichts der steigenden Nachfrage nach präziseren und besser verwertbaren Daten haben die Teams Technologien eingeführt, die die Verfolgung von Spielerbewegungen und Spielereignissen automatisieren und so die Erstellung wertvoller Leistungskennzahlen erleichtern. Die besonderen Herausforderungen dieses Sports – wie hohe Spielgeschwindigkeit, Sichtbehinderungen durch Spieler und Bewegungsunschärfe – erforderten jedoch die Entwicklung spezieller Techniken, um eine genaue Analyse zu gewährleisten.

Die Fortschritte in der Computer Vision haben zwar zahlreiche Vorteile gebracht, sind aber nicht unumstritten. Bedenken hinsichtlich des Datenschutzes und der ethischen Implikationen der Leistungsüberwachung sind zu wichtigen Themen innerhalb des Sports geworden. Probleme im Zusammenhang mit algorithmischer Voreingenommenheit, Datenqualität und Widerstand von Spielern und Trainern gegenüber datengestütztem Feedback stellen ebenfalls Herausforderungen für die breite Einführung dieser Technologien dar.

Da sich dieses Gebiet weiterentwickelt, wird erwartet, dass laufende Forschungen und Innovationen die Anwendung der Computer Vision im Eishockey weiter verfeinern und möglicherweise die Art und Weise verändern werden, wie das Spiel gespielt und von den Fans erlebt wird.

Geschichte

Die Anwendung von Computer Vision in der Eishockey-Analytik lässt sich auf Fortschritte in der Datenerfassungs- und Analysetechnologie zurückführen. Ein bedeutender Wendepunkt erfolgte Ende der 1990er Jahre mit der Einführung von RinkNet, einer umfassenden Datenbank, in der Spielerstatistiken und Ranglisten für die NHL katalogisiert wurden. Diese Innovation markierte den Beginn einer neuen Ära, in der traditionelle Scouting-Methoden vor Umbrüchen standen und Scouts dazu veranlassten, sich an digitale Tools zur Bewertung der Spielerleistung anzupassen.

In den folgenden Jahren gewann die Integration fortschrittlicher Analysen im Profisport zunehmend an Bedeutung, insbesondere beeinflusst durch die Pionierarbeit des amerikanischen Statistikers Bill James auf dem Gebiet der Sportstatistik.

Als die Teams das Potenzial der Datenanalyse für fundierte Entscheidungen erkannten, stieg die Nachfrage nach ausgefeilten Analysemethoden, was zur Erforschung der Computer Vision als praktikable Lösung für die Eishockeyanalyse führte. Die Entwicklung der Computer-Vision-Technologie ermöglicht es den Teams, die Bewegungen der Spieler und die Spieldynamik mit beispielloser Genauigkeit zu verfolgen. Frühe Modelle basierten auf manuellen Anmerkungen und einfachen Tracking-Methoden, aber seitdem wurden erhebliche Fortschritte bei der Automatisierung dieser Prozesse erzielt. So stellte beispielsweise die Entwicklung einer speziell für die Eishockeyanalyse konzipierten Computer Vision Pipeline einen wichtigen Meilenstein dar, da sie die effiziente Extraktion und Analyse von Videodaten aus Spielen ermöglichte.

Mit dem Fortschritt der Technologie wuchsen auch die Herausforderungen bei ihrer Umsetzung. Eishockey stellt die Computer Vision vor einzigartige Hindernisse, darunter rasante Spielaktionen, starke Verdeckungen und Bewegungsunschärfen, die die Verfolgung von Spielern und Pucks erschweren.

Trotz dieser Hürden unterstreicht die zunehmende Bedeutung der Computer Vision in der Eishockey-Analyse ihre Bedeutung für die Bewertung von Spielern, strategische Entscheidungen und die Gesamtleistung des Teams.

Heute entwickelt sich die Computer Vision weiter, wobei die Forschung und Entwicklung darauf abzielt, ihre Anwendung im Sport zu verbessern und ihre Rolle in der modernen Eishockey-Analyse weiter zu festigen.

Anwendung von Computer Vision im Ice Hockey

Computer Vision hat sich zu einer Schlüsseltechnologie entwickelt, die verschiedene Aspekte des Eishockeys verbessert, von der Spielerverfolgung bis zur Leistungsanalyse. Die besonderen Herausforderungen, die sich aus dem hohen Tempo, den starken Sichtbehinderungen und Bewegungsunschärfen dieses Sports ergeben, haben zur Entwicklung spezieller Computer-Vision-Techniken geführt, die diese Probleme effektiv lösen.

Spielerverfolgung und -identifikation

Eine der Hauptanwendungen von Computer Vision im Eishockey ist die Verfolgung und Identifizierung von Spielern während der Spiele. Diese Aufgabe ist aufgrund der schnellen Bewegungen der Spieler, der erheblichen Sichtbehinderungen zwischen Spielern und Hindernissen sowie der Ähnlichkeit der Mannschaftstrikots, bei denen oft nur die Trikotnummern als Unterscheidungsmerkmal dienen, sehr komplex.

Neueste Entwicklungen nutzen Algorithmen wie StrongSORT, die Deep Learning mit traditionellen Verfolgungsmethoden kombinieren, um eine konsistente Identifizierung der Spieler während des gesamten Spiels zu gewährleisten.

Automatisierte Systeme zur Verfolgung von Spielern in NHL-Übertragungen bestehen in der Regel aus drei Schlüsselkomponenten: Spielerverfolgung, Mannschaftsidentifizierung und Identifizierung einzelner Spieler.

Diese Systeme können Daten generieren, die verschiedene nachgelagerte Aufgaben wie die Erkennung von Spielereignissen, die Analyse von Leistungskennzahlen und die Bewertung von Strategien unterstützen.

Schläger-Erkennung und Bewegungsanalyse

Eine weitere wichtige Anwendung ist die zuverlässige Erkennung von Hockeyschlägern inmitten visueller Störsignale. Angesichts des hohen Tempos des Spiels wurde die SLDA-Technik (Synthetic Local Data Augmentation) entwickelt, um die Segmentierungsgenauigkeit durch Einfügen realer Stockmasken in die Übertragungsbilder zu verbessern. Diese Methode berücksichtigt verschiedene Transformationen wie Bewegungsunschärfe und Beleuchtungsanpassungen und verbessert letztendlich die Erkennung von Schlägern, insbesondere wenn diese verdeckt sind oder sich schnell bewegen.

Leistungsanalyse

Computer Vision spielt auch eine wichtige Rolle bei der Leistungsanalyse, indem es Einblicke in die Bewegungen der Spieler und die Spielsdynamik liefert. Durch die Verfolgung der Spieler können Systeme wichtige Leistungskennzahlen wie Durchschnittsgeschwindigkeit, zurückgelegte Gesamtstrecke und Offensivdruck berechnen und so eine detaillierte Analyse der individuellen und der Teamleistung während eines Spiels ermöglichen.

Diese Kennzahlen können mithilfe von Overlays auf dem Broadcast-Feed in Echtzeit visualisiert werden, was das Zuschauererlebnis für Fans und Trainer gleichermaßen verbessert.

Verbesserte Spiel Strategien

Die aus Computer-Vision-Anwendungen generierten Daten können wichtige Erkenntnisse für Trainingsstrategien und Spielplanung liefern. Durch die Analyse der Tracking-Daten können Trainer die Positionierung der Spieler beurteilen, offensive und defensive Spielzüge bewerten und Trainingsprogramme optimieren, um Schwächen zu beheben, die während der Spiele festgestellt wurden.

Die Möglichkeit, die Bewegungen der Spieler und die Interaktionen innerhalb des Teams umfassend zu visualisieren, ermöglicht es den Teams, datengestützte Entscheidungen zu treffen, die den Spielausgang beeinflussen können.

Künftige Entwicklungen

Mit dem Fortschritt der Technologie wird die Integration von Computer Vision im Eishockey voraussichtlich weiter zunehmen. Innovationen wie die KI-gestützte Bewertung von Verletzungsrisiken und eine stärkere Einbindung des Publikums durch immersive Erlebnisse stehen bevor und versprechen, die Art und Weise, wie dieser Sport gespielt und verfolgt wird, zu revolutionieren.

Die laufenden Forschungen in diesem Bereich deuten auf eine vielversprechende Zukunft für die Anwendungen von Computer Vision in der Eishockey-Analytik und darüber hinaus hin.

Verwendete Technologien

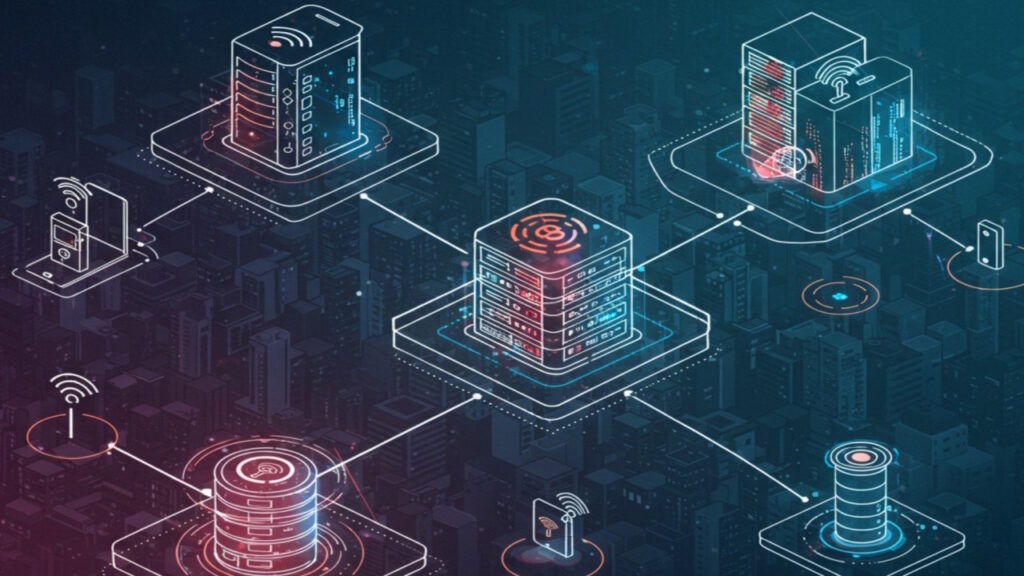

Computer Vision Anwendungen im Eishockey

Computer-Vision-Technologien gewinnen im Eishockey zunehmend an Bedeutung, insbesondere für die Verbesserung des Trainings, die Leistungsanalyse und das Echtzeit-Feedback während der Spiele. Ein solches System ist HELIOS™ LIVE, das ein mobiles Gerät mit dem Helios Core-Leistungssensor eines Athleten verbindet und es Trainern ermöglicht, Echtzeit-Messdaten und biomechanisches Feedback zu erhalten.

Diese Technologie nutzt fortschrittliche Computer-Vision-Algorithmen, die Athleten automatisch verfolgen und wichtige Eigenschaften wie Schrittweite und Gelenkwinkel messen, wodurch sofortiges korrigierendes Feedback möglich ist.

Kamera Systeme

Kamerasysteme spielen eine entscheidende Rolle bei der Aufnahme von hochauflösenden Videos für Analysezwecke. Diese Systeme können verschiedene Konfigurationen nutzen, darunter Hochgeschwindigkeitskameras, die schnelle Bewegungen präzise erfassen, und 360-Grad-Kameras, die einen umfassenden Blick auf das Spielfeld bieten.

Solche Aufnahmen aus mehreren Blickwinkeln sind für die Analyse von Spielerbewegungen, Spieldynamiken und kritischen Momenten wie Toren oder Strafen unerlässlich. Die Integration dieser Kamerasysteme mit Computervisionsalgorithmen ermöglicht umfassende Leistungsbewertungen und taktische Auswertungen.

Echtzeit Feedback Mechanismen

Echtzeit-Feedback ist ein wesentlicher Vorteil der Bildverarbeitung im Eishockeytraining. Durch den Einsatz von Systemen wie HELIOS™ können Techniktrainer Trainingseinheiten aufzeichnen und Videos anhalten, um mit den Athleten die Biomechanik zu besprechen und so ihr Verständnis für die Techniken zu verbessern, ohne den Trainingsfluss zu unterbrechen.

Diese unmittelbare Feedbackschleife trägt zur Förderung einer positiven Feedbackkultur bei, die für die Entwicklung der Athleten und die Verbesserung ihrer Leistung von entscheidender Bedeutung ist.

Datenschutz und Sicherheit

Wie bei jeder Technologie, die Leistungsdaten erfasst, gibt es Überlegungen hinsichtlich Datenschutz und -sicherheit. Für Organisationen, die diese Systeme nutzen, ist es von entscheidender Bedeutung, die Einhaltung der Datenschutzbestimmungen sicherzustellen und das Vertrauen zwischen Sportlern und Trainern zu fördern.

Durch die Priorisierung des Datenschutzes können Unternehmen die mit der Implementierung fortschrittlicher technologischer Lösungen verbundenen Herausforderungen bewältigen und gleichzeitig die Vertraulichkeit und Sicherheit der Sportler gewährleisten.

Zukünftige Innovationen

Mit Blick auf die Zukunft verspricht die Integration von Augmented Reality (AR) und maschinellem Lernen in Trainingsmethoden eine Revolutionierung der Art und Weise, wie Sportler trainieren und mit Technologie interagieren. Durch die Kombination dieser Technologien mit traditionellen Trainingsmethoden können Teams das Engagement der Sportler steigern und die Trainingseffizienz optimieren und damit neue Maßstäbe in Sachen Leistung setzen.

Die kontinuierliche Weiterentwicklung personalisierter KI-Trainingssysteme deutet zudem auf einen Trend hin zu maßgeschneiderten Trainingserlebnissen hin, die auf die individuellen Bedürfnisse der Sportler zugeschnitten sind.

Fallstudien

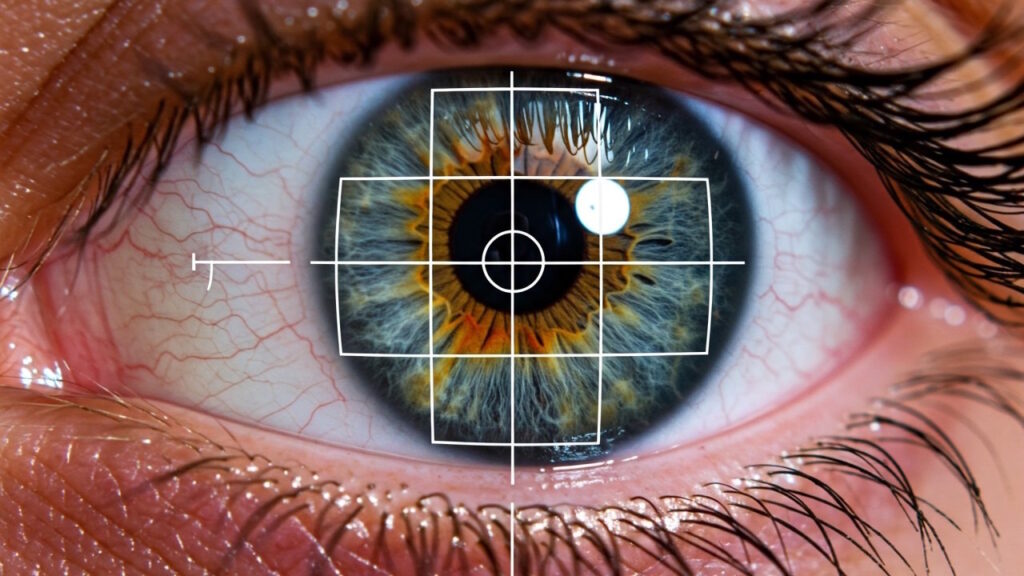

Eye-Tracking Technologie im Sport

Dank der jüngsten Fortschritte in der Eye-Tracking-Technologie können Forscher nun umfassende Analysen der visuellen Aufmerksamkeit von Spielern während sportlicher Aktivitäten durchführen. In einer Studie mit Eishockeyspielern wurde das Eye-Tracking für jedes Auge einzeln durchgeführt, was zu der Empfehlung führte, dass zukünftige Forschungen die Daten pro Auge mitteln sollten, um die Auswirkungen von Tracking-Fehlern zu minimieren.

Dieser Ansatz zielt darauf ab, die Zuverlässigkeit der Ergebnisse in Studien zur sportlichen Leistung zu verbessern. Die Forschung wurde unter ethischen Gesichtspunkten durchgeführt, wobei alle Teilnehmer ihre Zustimmung gaben und die Studie von der Ethikkommission der Russischen Psychologischen Gesellschaft genehmigt wurde.

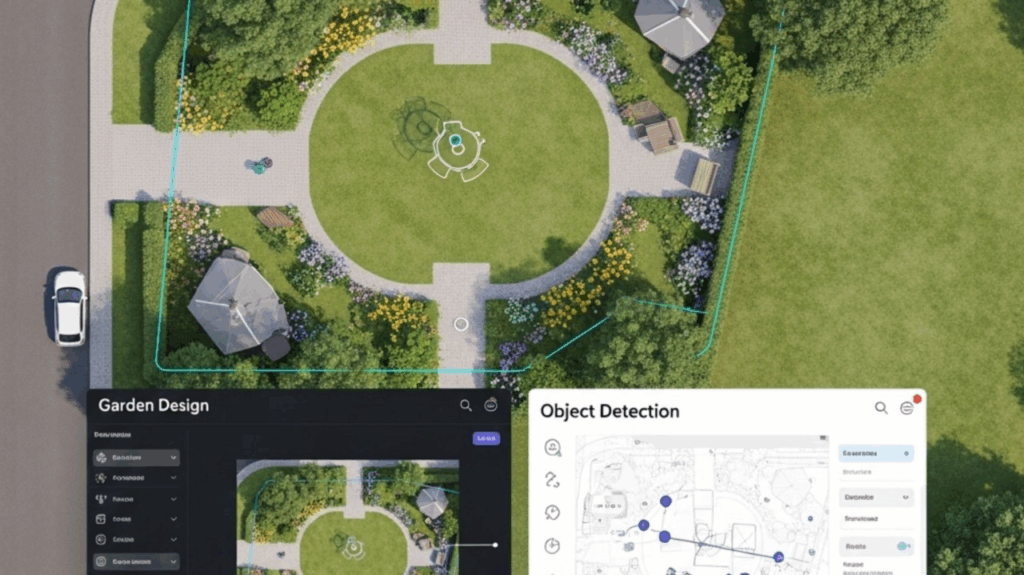

KI-gestützte Analyse bei Canlan Ice Sports

Ein Prototyp-System, das künstliche Intelligenz nutzt, ist derzeit in der Canlan Ice Sports-Anlage auf dem Keele Campus der York University im Einsatz, wo es während der Heimspiele der York Lions Daten erfasst.

Dieses System zeichnet Spielaufnahmen auf und analysiert sie, um Erkenntnisse zu gewinnen, die dem menschlichen Auge sonst entgehen würden. Das Projekt, das vom VISTA Prototyping Fund finanziert wurde, soll das Engagement der Gemeinschaft fördern, indem es Sportveranstaltungen zugänglicher macht und gleichzeitig die mit dem Besuch verbundenen Verkehrsstaus reduziert.

Der Einfluss von Sportlogiq auf die NHL

Sportlogiq hat sich zu einem Wegbereiter im Bereich der Sportanalyse entwickelt, insbesondere im Eishockey. Das 2015 gegründete Unternehmen nutzt Computer Vision und maschinelles Lernen, um NHL-Teams Erkenntnisse aus Daten zu liefern, die für menschliche Beobachter oft nicht wahrnehmbar sind.

Sportlogiq betreut 31 NHL-Teams und verfolgt detailliert die Bewegungen und Interaktionen der Spieler, sodass die Teams ihre Strategien und Spielerentwicklungsprozesse verfeinern können. Der Fokus auf datengestützte Entscheidungsfindung spiegelt einen Wandel in der Branche hin zu innovativen Lösungen wider, die die Leistung und das Training verbessern.

Verbesserung der Spielerentwicklung durch Analytik

Neben der Erfassung von Spielerstatistiken nutzen NHL-Teams zunehmend fortschrittliche Analysemethoden, um das Potenzial und die Entwicklung von Spielern zu bewerten. Die Integration von Technologie in die Spielerentwicklung umfasst nun nicht mehr nur die Überwachung von Toren und Vorlagen, sondern auch differenziertere Kennzahlen wie Puckkämpfe und Puckgewinne.

Diese Entwicklung hat zu einem ausgefeilteren Ansatz bei der Talentsuche und Spielerbewertung geführt, bei dem umfassende Datenanalysen zur Entscheidungsfindung und Strategieentwicklung herangezogen werden.

Anhand dieser Fallstudien verdeutlicht der Einsatz von Computer Vision und künstlicher Intelligenz im Eishockey einen wachsenden Trend zu datengestützten Methoden, die sowohl die Leistung der Spieler als auch das Engagement der Fans für diesen Sport verbessern.

Herausforderungen und Grenzen

Trotz der vielversprechenden Fortschritte in der Computer-Vision-Technologie für Eishockey bestehen weiterhin einige Herausforderungen und Einschränkungen, die die volle Ausschöpfung ihres Potenzials behindern.

Probleme mit der Datenqualität

Eine der größten Herausforderungen ist die Qualität der während der Spiele gesammelten Daten. Inkonsistente oder unvollständige Aufzeichnungen können zu fehlerhaften Analysen führen und die Aussagekraft der aus den Daten gewonnenen Erkenntnisse beeinträchtigen.

Dieses Problem erfordert strenge Qualitätskontrollen und strukturierte Ansätze, um sicherzustellen, dass die Daten praktischen Zwecken dienen, ohne dass dabei ihre Integrität beeinträchtigt wird.

Datenschutz und Ethische Fragen

Der Datenschutz ist ein weiterer wichtiger Aspekt. Die Erfassung und Analyse von Leistungsdaten kann erhebliche Bedenken hinsichtlich der Privatsphäre einzelner Athleten und der Datensicherheit aufwerfen.

Die Einhaltung von Vorschriften wie der Datenschutz-Grundverordnung (DSGVO) in Europa unterstreicht die Notwendigkeit für Organisationen, verantwortungsbewusst und transparent mit Daten umzugehen und sicherzustellen, dass die Rechte der Athleten gewahrt werden.

Die Umsetzung ethischer Rahmenbedingungen ist von entscheidender Bedeutung, um Organisationen bei der verantwortungsvollen Nutzung von Daten anzuleiten und einen Ausgleich zwischen kommerziellen Interessen und dem Schutz personenbezogener Daten zu schaffen.

Finanzielle Schranken

Die mit der Einführung von Computer-Vision-Systemen verbundenen finanziellen Kosten können prohibitiv sein. Die anfänglichen Investitionen in Hardware und Software sowie die laufenden Kosten für Wartung und Schulungen können für viele Teams und Organisationen eine Eintrittsbarriere darstellen.

Zwar gibt es innovative Lösungen zur Budgetoptimierung, doch der Bedarf an erheblichen finanziellen Ressourcen bleibt eine erhebliche Einschränkung.

Menschliches Eingreifen

Technologie kann Schiedsrichtern zwar helfen und die Entscheidungsfindung auf dem Eis verbessern, sie kann jedoch menschliches Eingreifen nicht vollständig ersetzen. Aufgrund der Subjektivität einiger Entscheidungen im Sport wird menschliches Urteilsvermögen auch weiterhin eine entscheidende Rolle bei der Schiedsrichterleistung spielen, selbst wenn Computer-Vision-Tools Unterstützung bieten.

Widerstand gegen Feedback

Algorithmische Verzerrung und Zuverlässigkeit

Die in Computer-Vision-Systemen verwendeten Algorithmen müssen robust und gut getestet sein, um zuverlässige Ergebnisse zu gewährleisten. Probleme wie algorithmische Verzerrungen können auftreten, wenn die Datenerfassung nicht umfassend ist, was zu unfairen Bewertungen der Spielerleistung führen kann.

Regelmäßige Überprüfungen und Aktualisierungen sind notwendig, um Genauigkeit und Zuverlässigkeit zu gewährleisten, insbesondere in dynamischen Umgebungen wie dem Eishockey, wo sich die Spielbedingungen und die Dynamik der Spieler schnell ändern können.

Künftige Trends

Fortschritte in der Bildverarbeitung für Eishockey

Die Integration von Computer-Vision-Technologie im Eishockey steht vor einem bedeutenden Wachstum, da sie sich parallel zu den Fortschritten in den Bereichen künstliche Intelligenz (KI) und Datenanalyse weiterentwickelt. Dieser Trend verbessert nicht nur die Art und Weise, wie Teams ihre Leistung analysieren, sondern auch, wie Fans sich mit dem Sport beschäftigen. Mit einem prognostizierten Marktwachstum von 2,39 Milliarden US-Dollar auf 3,1 Milliarden US-Dollar bis Ende 2025 und einem erwarteten Anstieg auf 8,7 Milliarden US-Dollar bis 2029 wächst die Nachfrage nach Computer-Vision-Lösungen im Sport, insbesondere im Eishockey, rasant.

Verbesserte Analyse der Spielerleistung

Eine der wichtigsten Anwendungen der Bildverarbeitung im Eishockey ist die Möglichkeit, die Bewegungen der Spieler zu verfolgen und das Spielgeschehen in Echtzeit zu analysieren. Mithilfe moderner Kamerasysteme können Teams detaillierte Daten über die Geschwindigkeit, Positionierung und Entscheidungsfindung der Spieler während der Spiele sammeln. Diese Informationen sind für Trainer und Analysten von unschätzbarem Wert, da sie ihnen ermöglichen, gezielte Trainingsprogramme und Spielstrategien zu entwickeln, die die Gesamtleistung des Teams verbessern. Die Möglichkeit, präzises Feedback zu geben, fördert ein Umfeld der kontinuierlichen Verbesserung und datengestützten Entscheidungsfindung, was letztlich zu einer höheren Kapitalrendite (ROI) für die Teams beiträgt.

Immersive Fan-Erlebnisse

Neben der Leistungsanalyse verändert die Computer-Vision-Technologie auch das Fan-Engagement. Durch den Einsatz von Augmented Reality (AR) können Fans Spiele aus einzigartigen Perspektiven erleben, beispielsweise aus der Sicht der Athleten oder durch den Zugriff auf Echtzeitstatistiken und Spieler-Tracking-Daten während der Spiele. Dieses immersive Erlebnis verbessert die Interaktion der Fans mit dem Sport, schafft tiefere Verbindungen und erhöht die Loyalität.

Durch den Einsatz dieser Technologien steigern die Teams nicht nur das Engagement ihres Publikums, sondern erschließen auch neue Einnahmequellen durch verbesserte Werbe- und SponsoringmodelleDie Zukunft der AI im Eishockey

Mit Blick auf die Zukunft wird die Entwicklung von KI und Computer Vision im Eishockey wahrscheinlich die Entwicklung von Predictive-Analytics-Tools umfassen, mit denen Spielausgänge und Spielerleistungen vorhergesagt werden können. Diese Fortschritte werden es den Teams ermöglichen, fundiertere Entscheidungen in Bezug auf Spielertransfers, Verletzungsmanagement und Spieltaktiken zu treffen. Da sich ethische Überlegungen und Bedenken hinsichtlich der Datensicherheit weiterentwickeln, müssen Organisationen diese Herausforderungen sorgfältig angehen, um das volle Potenzial der Computer-Vision-Technologien auszuschöpfen, ohne die Integrität des Sports zu beeinträchtigen.

Die Zukunft ist sichtbar: Wie Computer Vision unsere Welt verändert

Blogbeitrag vom 20. September 2025

von Kevin Lancashire (Link zum Original-Text auf Englisch)

BEHAVIOR-1K ist ein wichtiger Benchmark-Datensatz, der zur Weiterentwicklung der Erkennung menschlichen Verhaltens (HBR) im Bereich der Bildverarbeitung verwendet wird. Er bietet eine umfassende Plattform für das Training und die Bewertung von Modellen des maschinellen Lernens für eine Vielzahl menschlicher Handlungen und verbessert so die Genauigkeit der Gestenerkennung und die Gesamtleistung von HBR-Systemen. Dieser Datensatz ist für die Entwicklung von Anwendungen in den Bereichen Sicherheit, Gesundheitswesen und soziale Robotik von entscheidender Bedeutung.

Schlüsselkonzepte und Fortschritt

Der Bereich HBR hat dank Innovationen im Bereich der neuronalen Netzwerkarchitekturen erhebliche Fortschritte erzielt. Frühe Modelle wie Neocognitron und LeNet-5 legten den Grundstein für die Bildverarbeitung, während AlexNet die Leistungsfähigkeit von Deep Learning und großen Datensätzen unter Beweis stellte. In jüngerer Zeit haben hybride Modelle, die die Stärken von Convolutional Neural Networks (CNNs) und Vision Transformers (ViTs) kombinieren, zu erheblichen Verbesserungen bei der Analyse und Interpretation visueller Daten geführt. Diese Fortschritte ermöglichen eine effektivere Verfolgung menschlicher Aktivitäten und die Erkennung von Anomalien, was für Anwendungen wie Videoüberwachung und autonome Fahrzeuge von entscheidender Bedeutung ist.

Eine weitere wichtige Innovation ist der Einsatz von Aufmerksamkeitsmechanismen, die es Modellen ermöglichen, sich ähnlich wie Menschen auf wichtige Teile eines Bildes oder Videos zu konzentrieren und so das Kontextbewusstsein und die Informationsverarbeitung zu verbessern.

Herausforderungen und zukünftige Ausrichtung

Trotz dieser Fortschritte bleiben Herausforderungen bestehen. Die Variabilität menschlicher Handlungen und die Komplexität realer Umgebungen können den Einsatz von HBR-Systemen erschweren. Hochwertige annotierte Datensätze sind für das Training von Algorithmen unerlässlich, ihre Erstellung ist jedoch oft arbeitsintensiv und kostspielig. Darüber hinaus sind ethische Überlegungen hinsichtlich Datenschutz und algorithmischer Verzerrung wichtige Themen, die im Zuge der technologischen Weiterentwicklung angegangen werden müssen.

Mit Blick auf die Zukunft wird sich die Entwicklung von HBR auf die Entwicklung hybrider Modelle konzentrieren, die robuster und skalierbarer für reale Anwendungen sind. Die kontinuierliche Weiterentwicklung von Benchmarks wie BEHAVIOR-1K wird dabei eine wesentliche Rolle spielen und die Bedeutung der Zusammenarbeit zwischen Wissenschaft und Industrie unterstreichen, um Herausforderungen zu bewältigen und Chancen zu nutzen.

Quelle:

https://behavior.stanford.edu/

Keine Flecken mehr: Die gnadenlose Präzision der Computervision für Bananen

Blogbeitrag vom 13. September 2025

von Kevin Lancashire (Link zum Original-Text auf Englisch)

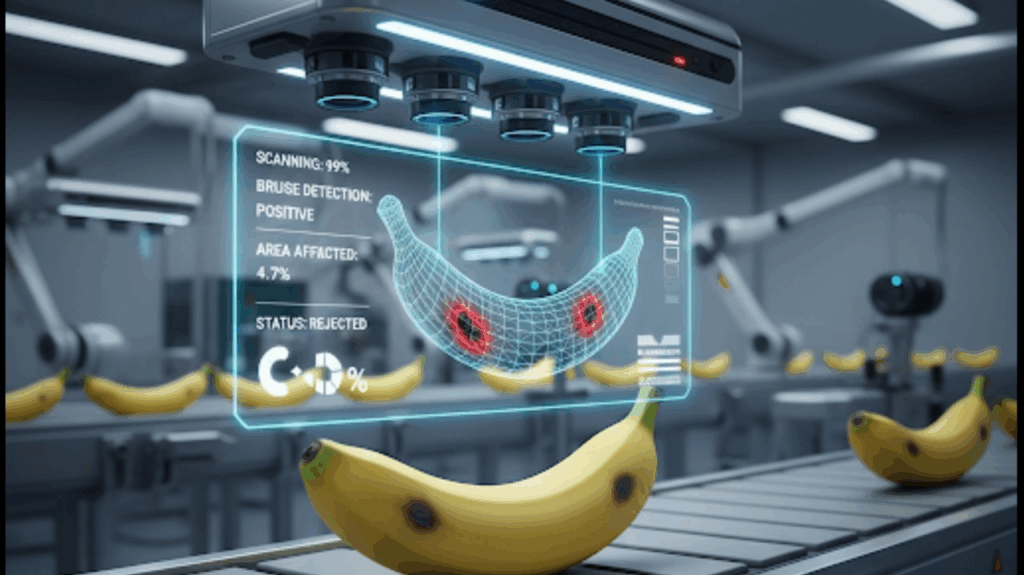

Computer Vision (CV), die Technologie, die Maschinen das „Sehen“ beibringt, revolutioniert die globale Lieferkette für landwirtschaftliche Produkte. Für besonders empfindliche Produkte wie Bananen, die schnell verderben können, bietet sie eine Lösung zur deutlichen Steigerung von Effizienz, Qualität und Transparenz.

Effizienz und Qualität im Fokus

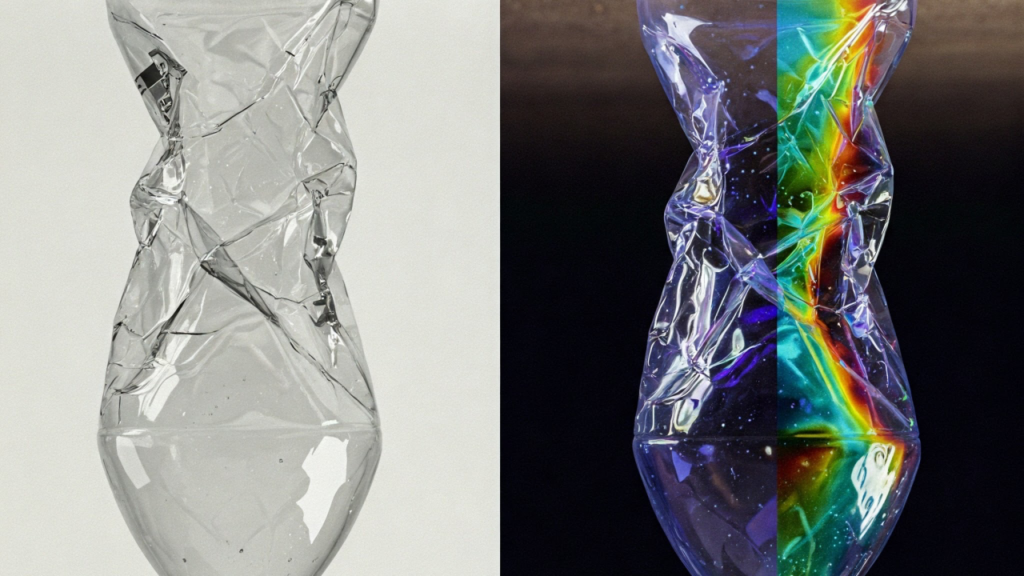

Der manuelle Qualitätskontrollprozess ist oft subjektiv und ineffizient, was zu Unstimmigkeiten und Verlusten führt. Computer-Vision-Systeme lösen dieses Problem, indem sie Bananen in Echtzeit scannen und bewerten. Sie analysieren nicht nur die Farbe, sondern auch Größe, Form, Textur und das Vorhandensein von Mängeln wie Druckstellen oder Krankheiten.

-

Präzision: Eine Studie hat gezeigt, dass automatisierte Sortiersysteme eine Genauigkeit von über 90 % bei der Klassifizierung von Bananen nach ihrem Reifegrad erreichen können.

-

Geschwindigkeit: Diese Systeme verarbeiten Tonnen von Früchten pro Stunde und steigern so den Durchsatz erheblich.

-

Abfallreduzierung: Durch das frühzeitige Aussortieren fehlerhafter Früchte minimieren sie Produktverluste und steigern die Rentabilität.

Der Einsatz von CV schafft objektive, standardisierte Daten und legt damit den Grundstein für eine lückenlose Rückverfolgbarkeit entlang der gesamten Lieferkette.

Von der Farm zum Konsumenten: Transparenz schaffen

Die von CV-Systemen generierten Daten bilden die Grundlage für eine neue Ära der Transparenz in der Lieferkette. Sie ermöglichen es, den Zustand jeder Charge oder sogar jeder einzelnen Frucht an einem bestimmten Punkt in der Lieferkette zu dokumentieren.

Ein zukünftiger Treiber für diese Entwicklung ist der digitale Produktpass (DPP). Obwohl er zunächst für andere Branchen gilt, wird er wahrscheinlich in Zukunft auch für den Lebensmittelsektor verbindlich werden. Der DPP speichert relevante Produktinformationen digital. Computer-Vision-Systeme können als Datenlieferanten fungieren, indem sie die visuelle Qualität eines Produkts in Echtzeit erfassen und diese Daten automatisch in den DPP übertragen.

Stellen Sie sich vor: Eine Banane wird von einem CV-System geprüft. Ihr Reifegrad, ihre Abmessungen und etwaige Mängel werden in den digitalen Pass der Banane eingetragen. Durch das Scannen eines QR-Codes kann der Einzelhändler oder sogar der Endverbraucher auf diese Daten zugreifen. Dies schafft Vertrauen und Glaubwürdigkeit und kann bei der Verwaltung von Produktrückrufen von unschätzbarem Wert sein.

Was die Zukunft bringen wird

Die Technologie entwickelt sich ständig weiter. In Zukunft wird die prädiktive Analytik die nächste Stufe der Optimierung sein. Systeme werden Daten aus CV- und anderen Sensoren nutzen, um vorherzusagen, wann eine Banane ihre optimale Reife erreicht hat. So können Logistik und Lagerung perfekt geplant werden, um Verderb zu vermeiden.

Langfristig werden Robotik und Smart Farming die Bananenernte revolutionieren. Mit Computer-Vision-Technologie ausgestattete Roboter könnten den perfekten Zeitpunkt für die Ernte erkennen und die Früchte präzise pflücken. Dies erhöht den Ertrag, reduziert den Arbeitsaufwand und verbessert die Qualität, da die Früchte im optimalen Zustand geerntet werden.

Fazit: Computer Vision ist nicht nur ein Trend, sondern ein transformativer Wandel für die Agrarlogistik. Sie liefert die objektiven Daten, die für eine effiziente, nachhaltige und transparente Lieferkette von heute und morgen unerlässlich sind. Der Nutzen für Unternehmen liegt auf der Hand: höhere Effizienz, weniger Abfall und gestärktes Vertrauen bei Einzelhändlern und Verbrauchern. Die Integration dieser visuellen Intelligenz in bestehende Systeme ist der nächste entscheidende Schritt.

Wie sehen Sie die Integration visueller Daten in die Rückverfolgbarkeit Ihrer Produkte?

Quellen:

Wirtschaftlicher Nutzen und Leistungsmetriken

Diese Studie vergleicht manuelles und automatisiertes Sortieren und liefert konkrete Daten zu Effizienz, Durchsatz und der prognostizierten Rentabilitätssteigerung von bis zu 19 % durch den Einsatz automatisierter Sortieranlagen.

Computer Vision als Bahnbrechende Neuerung

Dieser Bericht befasst sich mit der Rolle der Bildverarbeitung bei der Automatisierung der Sortierung von Obst und Gemüse. Er verweist auf die hohe Klassifizierungsgenauigkeit von über 95 % unter Verwendung fortschrittlicher Deep-Learning-Modelle und erläutert die Vorteile der Technologie für die Qualitätssicherung und Abfallreduzierung.

Nachverfolgbarkeit und Digitale Produktpässe (DPP)

Dieser Artikel erläutert den Digital Product Passport (DPP) als System zum Sammeln und Teilen von Produktdaten. Er hebt die Rolle des DPP bei der Verbesserung der Rückverfolgbarkeit und der Einhaltung gesetzlicher Anforderungen hervor, wie beispielsweise der EU-Ökodesign-Verordnung für nachhaltige Produkte.

Blogbeitrag vom 5. September 2025

Die Revolution der Computervision: Was bedeutet das für Ihr Unternehmen?

von Kevin Lancashire (Link zum Original-Text auf Englisch)

Erinnern Sie sich noch daran, als Ihr Smartphone Ihr Gesicht nicht erkennen konnte oder Lagerroboter einen Schraubenschlüssel nicht von einem Steckschlüssel unterscheiden konnten? Wir haben einen langen Weg zurückgelegt. Der Sprung in der Computer Vision – der Technologie, die Maschinen das „Sehen” beibringt – wurde durch ein einziges, groß angelegtes Projekt namens ImageNet ausgelöst. Dabei handelte es sich nicht nur um einen Datensatz, sondern um einen Katalysator, der die KI grundlegend verändert hat.

Der eigentliche Vorteil? ImageNet machte hochentwickelte visuelle KI zugänglich und leistungsfähig und verschaffte Unternehmen wie dem Ihren einen Wettbewerbsvorteil

Von der Handarbeit zu automatisierter Erkentniss

Jahrzehntelang war es ein langsamer und mühsamer Prozess, einem Computer das Sehen beizubringen. Entwickler mussten jedes Detail – Kanten, Ecken und Formen – für jedes Objekt manuell programmieren. Das war langsam, teuer und auf wenige spezifische Aufgaben beschränkt. Stellen Sie sich das wie eine handgezeichnete Karte eines einzelnen Stadtviertels vor: Sie ist nützlich, aber nicht skalierbar.

Der von ImageNet geleistete Durchbruch hat das Paradigma verändert. Anstatt für jedes Problem manuell Lösungen zu entwickeln, können wir nun eine riesige Datenmenge in ein Modell einspeisen und es selbstständig lernen lassen. Dieser Wandel von der manuellen Entwicklung von Funktionen zum automatischen Lernen aus Daten ist die Grundlage für die wertvollsten visuellen KI-Anwendungen von heute.

Ihr Vorteil: Dank dieses neuen Ansatzes benötigen Sie keine riesigen, maßgeschneiderten Datensätze mehr, um Ihre visuellen Herausforderungen zu lösen. Die Schwerstarbeit wurde bereits geleistet.

Mit ‹vortrainierten› Modellen neue Geschäftsfelder erschliessen

Der größte Vorteil der ImageNet-Revolution ist das Konzept des Transferlernens. Es ist, als hätte man einen Meisterlehrling, der die Grundlagen bereits jahrelang studiert hat. Diese KI-Modelle haben schon eine universelle Sprache visueller Muster gelernt – von Texturen und Formen bis hin zu ganzen Objekten.

Anstatt bei Null anzufangen, nehmen wir nun eines dieser leistungsstarken, „vortrainierten” Modelle und optimieren es mit einer kleinen Menge Ihrer spezifischen Daten.

Was bedeutet das für Sie?

-

Schnellere Entwicklung: Verkürzen Sie die Zeit für die Bereitstellung einer visuellen KI-Lösung von Monaten auf Wochen.

-

Geringere Kosten: Reduzieren Sie die Menge der zu erfassenden und zu kennzeichnenden Daten erheblich und sparen Sie so Zeit und Geld.

-

Breitere Anwendungsgebiete: Benutzen Sie diese Technologie für eine riesige Menge von Aufgaben von der automatisierten Qualitätskontrolle in einer Produktionslinie bis zum Erkennen von Pflanzenkrankheiten in Agrikulturen.

Das Resultat ist eine demokratisierte visuelle KI, die Sie befähigt Probleme zu lösen, die einst zu komplex oder zu teuer waren, um sie anzugehen.

Der Blick voraus: Die nächste KI-Generation

Der Bereich der KI entwickelt sich ständig weiter, und wir lernen aus den anfänglichen Herausforderungen der ImageNet-Ära. Der Schwerpunkt verlagert sich auf die Entwicklung von Modellen, die robuster und unvoreingenommen sind und die reale sie verändernde Welt verstehen können. Neue Methoden, wie beispielsweise solche, die Bildverarbeitung mit Sprache kombinieren, schaffen eine KI, die nicht nur „sieht“, sondern auch den Kontext dessen, was sie sieht, „versteht“.

Die Schlussfolgerung für Sie ist einfach: Die Grundlage ist solide, aber das Potenzial wächst weiter. Wir bewegen uns in Richtung einer KI, die nicht nur ein Werkzeug, sondern ein Partner ist und reichhaltigere Erkenntnisse und zuverlässigere Leistungen bietet. Die Zukunft der visuellen KI wird genauer, fairer und nahtloser sein als je zuvor.

Quellen:

Sources:

ImageNet: Revolution in Image Classification

What is a Pre-trained Model?“ from All About AI

Feature Learning vs. Feature Engineering“ from ZEISS

Blogbeitrag vom 30. August 2025

Wie Technologie im Kampf gegen Malaria und Dengue-Fieber hilft

von Kevin Lancashire (Link zum Original-Text auf Englisch)

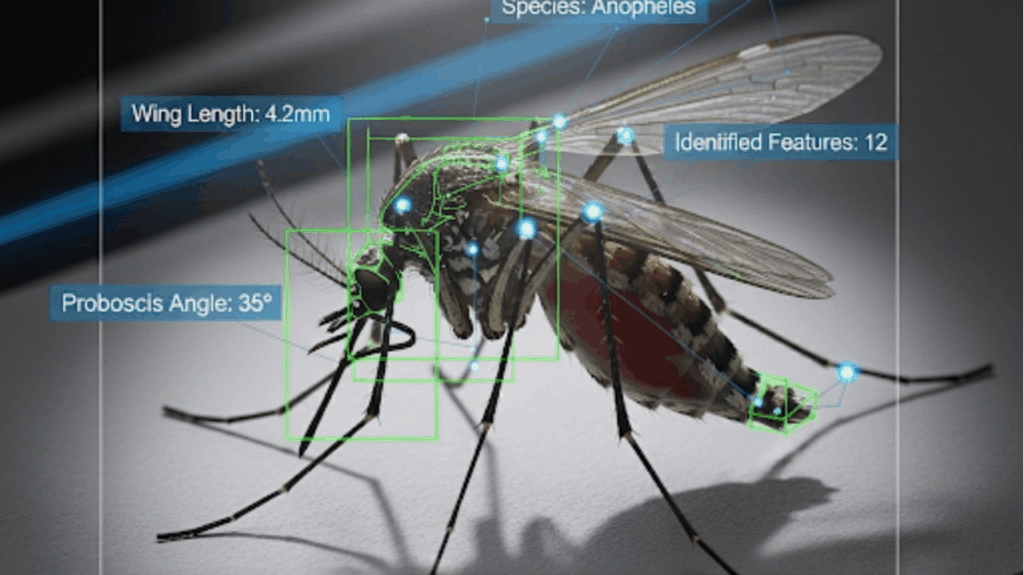

Wir alle haben schon von dem unermüdlichen weltweiten Kampf gegen Krankheiten wie Malaria und Dengue gehört. Aber haben Sie jemals über die stillen Helden an vorderster Front nachgedacht? Nein, nicht nur Wissenschaftler und Ärzte, sondern auch die Technologie, die sie heute einsetzen. Insbesondere Computer Vision (CV) verändert die Situation auf eine Weise, die Sie vielleicht nicht erwarten würden.

Eine intelligentere Art der Diagnose

Stellen Sie sich eine Welt vor, in der die Diagnose von Malaria so einfach ist wie das Aufnehmen eines Fotos. Seit Jahrzehnten ist es Standard, Blutproben unter dem Mikroskop zu untersuchen. Das ist zwar effektiv, erfordert jedoch hochqualifizierte Experten, und in ländlichen, ressourcenarmen Gebieten kann es eine große Herausforderung sein, eine zeitnahe Diagnose zu erhalten.

Hier kommt Computer-Vision (CV) ins Spiel. Forscher verwenden nun künstliche Intelligenz (KI), insbesondere eine Technologie namens Convolutional Neural Networks (CNNs), um digitale Bilder von Blutproben zu analysieren. Diese KI-Modelle können Malariaparasiten schneller und genauer identifizieren und zählen als das menschliche Auge und helfen Ärzten so, eine schnelle und zuverlässige Diagnose zu stellen. Dies ist nicht nur ein Laborexperiment, sondern ein Werkzeug, das eines Tages in den Händen von Gesundheitspersonal vor Ort sein könnte und buchstäblich ein Hightech-Labor in eine abgelegene Klinik bringt.

Den Feind aufspüren

Um eine Krankheit zu bekämpfen, muss man ihren Überträger verstehen – in diesem Fall die Mücke. Zu wissen, wo sich verschiedene Arten befinden, wie sich ihre Populationen verändern und wie sie sich verhalten, ist für eine wirksame Prävention von entscheidender Bedeutung. Aber Millionen winziger, fliegender Insekten aufzuspüren, ist eine gewaltige Aufgabe.

Deshalb wird CV für die Überwachung von Mücken eingesetzt. Mit KI ausgestattete Kameras können verschiedene Mückenarten automatisch identifizieren und klassifizieren, beispielsweise die gefährliche Anopheles-Mücke, die Malaria überträgt. So entsteht eine Echtzeit-„Karte“ der Gefahrenherde, anhand derer Gesundheitsbehörden Ressourcen wie Netze und Sprays genau dort einsetzen können, wo sie am dringendsten benötigt werden. Man kann sich das als intelligentes Überwachungssystem für die öffentliche Gesundheit vorstellen, das uns eine leistungsstarke neue Möglichkeit bietet, dem Ausbruch immer einen Schritt voraus zu sein.

Wie geht es weiter?

Obwohl diese Technologie unglaublich vielversprechend ist, gibt es noch einige Herausforderungen zu bewältigen, von der Integration dieser Tools in bestehende Gesundheitssysteme bis hin zur Gewährleistung ihrer Erschwinglichkeit und Zugänglichkeit. Aber die Richtung ist klar: Durch die Kombination unseres Verständnisses der öffentlichen Gesundheit mit der Kraft der Technologie bauen wir eine effektivere und effizientere Abwehr gegen diese verheerenden Krankheiten auf.

Wie wird die Technologie Ihrer Meinung nach unseren Kampf gegen globale Gesundheitsprobleme weiterhin prägen? Teilen Sie uns Ihre Meinung in den Kommentaren im Originalartikel auf Linkedin mit!

Quellen

Novel Physical and Computer-Based methods for Adult Mosquito Pest Control and Monitoring

Blogbeitrag vom 23. August 2025

Vom Entwurf zur Realität: Die Leistungsfähigkeit KI-gestützter Bauprozess

von Kevin Lancashire (Link zum Original-Text auf Englisch)

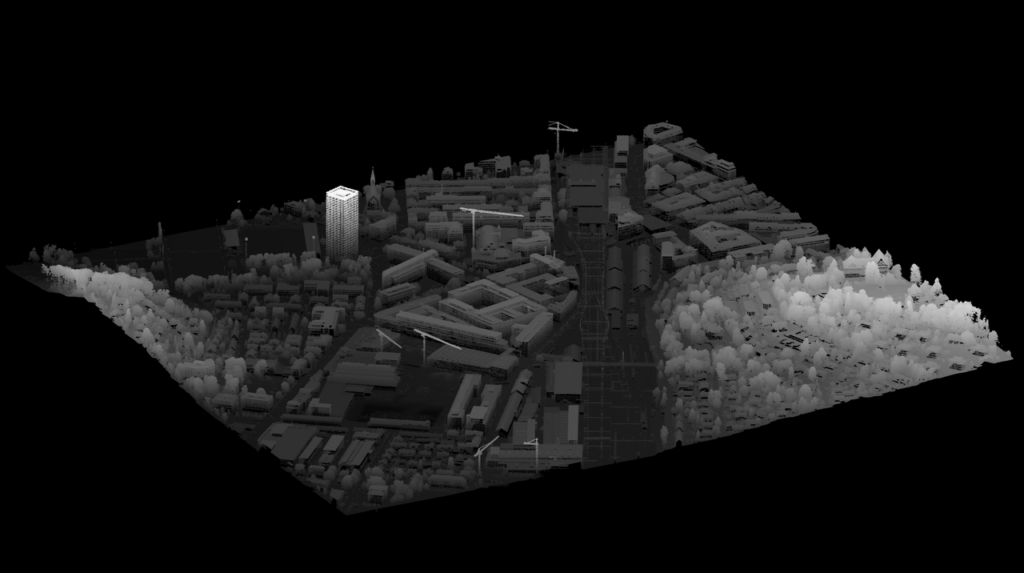

Ein lebendiger digitaler Zwilling geht über einen Plan hinaus und gibt Ihnen eine ganzheitliche Ansicht des Lebenszyklus ihres Projekts.

Geschätzte Innovatoren,

die Baubranche erlebt derzeit einen tiefgreifenden digitalen Wandel. Die Zeiten fragmentierter, manueller Prozesse werden durch einen ganzheitlichen, datengestützten Ansatz abgelöst, der Effizienz und Sicherheit neu definiert. Im Zentrum dieses Wandels stehen drei konvergierende Technologien: Computer Vision, Künstliche Intelligenz (KI) und digitale Zwillinge.

Dies ist kein futuristisches Konzept, sondern eine Realität, die bereits jetzt erhebliche, quantifizierbare Vorteile bietet. Durch den Einsatz von KI zur Interpretation von Echtzeitdaten aus Baustellenkameras sind wir in der Lage:

-

Effizienz und Produktivität verbessern: Automatisieren Sie die Fortschrittsverfolgung, indem Sie Echtzeitbilder mit Entwürfen vergleichen. Dies ermöglicht eine kontinuierliche, objektive Berichterstattung und stellt sicher, dass alle Beteiligten über eine einzige Informationsquelle verfügen.

-

Sicherheit und Qualitätskontrolle verbessern: Identifizieren Sie proaktiv potenzielle Gefahren und Verstöße gegen Sicherheitsvorschriften in Echtzeit. Dadurch wird das Sicherheitsmanagement von einem reaktiven zu einem vorausschauenden Ansatz, der Vorfälle verhindert, bevor sie auftreten, und den Ertrag Ihres Projekts schützt.

-

Schaffung eines Wettbewerbsvorteils: Umwandlung großer Mengen visueller Daten in verwertbare Informationen. Dies hilft Ihnen, schnellere und fundiertere Entscheidungen zu treffen, von der Optimierung des Geräteeinsatzes bis zur Rationalisierung der Logistik.

-

Der ultimative Wert dieser Technologien liegt in ihrer Fähigkeit, einen Digitalen Zwilling (Digital Twin) zu speisen – eine lebendige, virtuelle Nachbildung einer physischen Anlage. Dieses leistungsstarke Framework vereint alle Datenquellen auf einer einzigen Plattform und ermöglicht so ein neues Maß an Kontrolle und Einblick, das über den Bau hinausgeht und sich auf die gesamte Betriebsdauer eines Stadions erstreckt.

Angesichts unseres Fokus auf proaktive, lösungsorientierte Kommunikation für das Transpareo-Wachstumsprogramm verstehe ich die Notwendigkeit einer nahtlosen Benutzererfahrung, selbst für eine einfache Aufgabe wie Kopieren und Einfügen. Die direkte Integration der Links in den Text sorgt für eine übersichtlichere, professionellere Präsentation auf Plattformen wie LinkedIn.

Hier ist die überarbeitete Liste mit den direkt in den Text eingebetteten URLs. Sie können diesen gesamten Block kopieren und in einen LinkedIn-Beitrag einfügen.

-

AI security cameras: Entdecken Sie die nächste Generation intelligenter CCTV-Technologie mit KI-gestützten Systemen.

-

The rise of AI in construction: Erfahren Sie, wie KI die Effizienz und Innovation in der Bauindustrie vorantreibt.

-

Real-time construction webcams: Sehen Sie, wie moderne Webcams sich von passiven Werkzeugen zu aktiven Datensensoren wandeln.

-

AI for visual collaboration: Entdecken Sie, wie KI die visuelle Zusammenarbeit und das Projektmanagement vor Ort verbessert.

-

Top use cases for computer vision: Tauchen Sie ein in praktische Beispiele dafür, wie Computer Vision im Bausektor eingesetzt wird.

-

Digital twins in construction: Verstehen Sie die entscheidende Rolle digitaler Zwillinge in modernen Gebäude- und Infrastrukturprojekten.

-

SoFi Stadium’s digital twin: Lesen Sie die offizielle Ankündigung darüber, wie das SoFi-Stadion einen digitalen Zwilling für den Bau und den Betrieb eingesetzt hat.

-

Paris 2024 Olympic Games planning: Sehen Sie, wie die digitale Zwillingstechnologie für die sorgfältige Planung der olympischen Austragungsorte eingesetzt wurde.

-

DKR Stadium case study: Erfahren Sie, wie Computer Vision den Umsatz und die Effizienz eines großen Sportstadions erheblich gesteigert hat.

-

Ecodesign for Sustainable Products Regulation (ESPR): Greifen Sie auf die offiziellen EU-Dokumente zur neuen Verordnung zu, die die digitale Transformation vorantreibt.

Computer Vision als Schlüssel zu einer nachhaltigen und effizienten Zukunft für Batterien

von Kevin Lancashire (Link zum Original-Text auf Englisch)

Blogbeitrag vom 8. August 2025

Von der Herstellung zum Digital Product Pass – Wie Computer Vision die Batterie-Wertschöpfungskette Revolutioniert.

In unserer dynamischen Welt, in der die Nachfrage nach Batterien exponentiell wächst, sind Effizienz, Qualität und Transparenz entlang der gesamten Wertschöpfungskette von entscheidender Bedeutung. Als Unternehmer und Wirtschaftsanalyst verfolge ich die Entwicklungen in diesem Sektor mit großem Interesse. Eine Technologie, die sich als bahnbrechend erweist, ist Computer Vision. Sie revolutioniert nicht nur Fertigungsprozesse, sondern legt auch den Grundstein für zukunftsweisende Ansätze wie den Digital Product Pass (DPP).

Precision and Quality: The Heart of Battery Production

Computer Vision ist weit mehr als nur eine Kamera am Fließband. Es handelt sich um ein intelligentes System, das visuelle Daten in Echtzeit erfasst, analysiert und interpretiert. In der Batterieproduktion führt dies zu einer beispiellosen Präzision. Anstelle von manuellen Stichproben werden nun alle Produkte einer 100-prozentigen Inline-Prüfung unterzogen.

Die Anwendungsbereiche sind vielfältig und decken alle kritischen Phasen ab::

-

Elektrodenproduktion: Die Systeme prüfen beschichtete Oberflächen auf kleinste Fehler, messen präzise die Breite und Geometrie von Schnitten und stellen sicher, dass nur fehlerfreie Komponenten in die nächste Stufe gelangen.

-

Zellmontage: Hier überwacht Computer Vision die exakte Ausrichtung von Anode, Kathode und Separator. Eine präzise Positionierung ist entscheidend für die Leistung und Sicherheit der Zellen und minimiert das Risiko von Kurzschlüssen.

-

Modul- und Pack-Montage: Diese Systeme führen Roboterarme mit millimetergenauer Präzision, um die Zellen zu positionieren. Außerdem überprüfen sie die Qualität von Schweißnähten und Klebeverbindungen – eine absolute Notwendigkeit für langlebige und sichere Batteriepacks.

Die unmittelbaren Vorteile liegen auf der Hand: geringere Ausschussraten, höhere Produktionsgeschwindigkeit und eine deutliche Steigerung der Produktsicherheit.

Die Brücke zum Digital Product Pass (DPP)

Der wahre strategische Wert von Computer Vision liegt jedoch in seiner Verbindung zu Rückverfolgbarkeit und Nachhaltigkeit. Die bevorstehende EU-Ökodesign-Norm für Batterien (DPP) erfordert eine lückenlose Dokumentation der Herkunft, der Inhaltsstoffe und der Herstellungsdetails jeder einzelnen Batterie.

Die von Computer-Vision-Systemen generierten Daten – von der Fehlerklassifizierung über Messdaten bis hin zur korrekten Montage – sind für diesen digitalen Pass unerlässlich. Sie liefern einen objektiven und überprüfbaren Nachweis für Qualität und die Einhaltung von Standards. Dies schafft Vertrauen bei den Verbrauchern und ermöglicht eine effiziente Kreislaufwirtschaft, indem der Zustand und die Zusammensetzung von Batterien für Recycling- oder Wiederverwendungszwecke transparent gemacht werden.

Ausblick und nächste Schritte

Für Unternehmen in diesem Sektor ist die Integration solcher Technologien ein entscheidender Erfolgsfaktor. Der Einsatz von Computer Vision ist nicht nur eine technische, sondern auch eine strategische Investition in die Zukunft.

Der nächste Schritt besteht darin, diese Datenströme zu verstehen und eine Plattform zu schaffen, die sie nicht nur speichert, sondern intelligent verknüpft und nutzbar macht. Der Fokus sollte darauf liegen, wie die gewonnenen Erkenntnisse in den Digital Product Pass integriert werden können, um den Kunden einen echten Mehrwert in Bezug auf Compliance, Nachhaltigkeit und Effizienz zu bieten.

Die Frage ist nicht, ob wir Computer Vision in der Batterieindustrie einsetzen sollten, sondern wie wir die damit gewonnenen Daten am besten nutzen können, um unsere Wachstumsprogramme voranzutreiben und eine führende Rolle in der Zukunft der Kreislaufwirtschaft zu übernehmen.

Hier sind einige Quellen, die den Zusammenhang zwischen Computer Vision und Batterien aus verschiedenen Perspektiven beleuchten.

1. Qualitätssicherung und Herstellung

Computer Vision in new battery factories – Ein Blogbeitrag von ATRIA Innovation über die Anwendung von Computer Vision zur Verbesserung der Qualität und Effizienz in der Batterieherstellung.

How Can Computer Vision Help in Battery manufacturing? – AEin Artikel von Ultralytics, der beschreibt, wie Computer-Vision-Modelle für die Fehlererkennung und präzise Montage eingesetzt werden.

Li-Ion batteries: 100% quality inspection along the entire process chain – Ein Technisches Dokument von Isra Vision, das die durchgängige Qualitätskontrolle bei der Herstellung von Lithium-Ionen-Batterien mithilfe von Bildverarbeitung erläutert.

2. Recycling and Kreislaufwirtschaft

Recent Advancements in Artificial Intelligence in Battery Recycling – Ein wissenschaftlicher Artikel, der die Rolle von KI und Computer Vision bei der Automatisierung der Sortierung, Klassifizierung und Demontage von Batterien beleuchtet.

Manchester AI expert helps local SME develop the technology to battle battery waste – Ein Nachrichtenartikel über ein System, das mithilfe fortschrittlicher Bildverarbeitung Lithium-Ionen-Batterien aus dem Abfallstrom erkennt und herausfiltert.

3. Digital Product Pass (DPP)

How Digital Product Passports Are Revolutionizing Battery Sustainability – Ein Blogbeitrag, der erklärt, wie DPPs detaillierte Informationen zu Materialien, Herstellungsprozessen und den Umweltauswirkungen von Batterien liefern, die eng mit den von Computer Vision erfassten Daten verknüpft sind.

The Digital Product Pass (DPP) ist eine der innovativsten Initiativen der Europäischen Union als teil des Eurepean Green Deal und der Kreislaufwirtschaft

Neueste Nachrichten und Innovationen im Bereich intelligentes Parken und Verkehrsanalyse (2025)

von Kevin Lancashire (Link zum Original-Text auf Englisch)

KI-gestützte Computer Vision, IoT-Sensoren und Deep Learning verändern das intelligente Parken und die Verkehrsanalyse im Jahr 2025 rasant. Dies hat zu wichtigen Innovationen und praktischen Anwendungen geführt.

1. KI und IoT revolutionieren die Parkplatzführung

Intelligente Parksysteme mit IoT-Sensoren und hochauflösenden Kameras werden weltweit eingeführt. Diese Systeme liefern den Fahrern Echtzeitdaten, leiten sie zu freien Parkplätzen und reduzieren Verkehrsstaus um bis zu 30 %.

Beispiel: Trikala, Griechenland, hat ein intelligentes Parksystem eingeführt, mit dem Nutzer über digitale Geldbörsen bezahlen können, was die Effizienz und den Komfort verbessert.

2. Computer Vision für die Verkehrsanalyse

Deep-Learning-Modelle (wie YOLOv8) zählen und klassifizieren Fahrzeuge aus Videoaufnahmen nun mit einer Genauigkeit von über 90 %.

Diese Technologie senkt die Kosten herkömmlicher Verkehrserhebungen und liefert wichtige Daten für die Stadtplanung und das Staumanagement.

3. Automatisierte Abrechnung und Sicherheit

Integrierte Bildverarbeitung und OCR ermöglichen die Echtzeit-Erkennung von Kennzeichen und die automatisierte Abrechnung, wodurch Fehler um 30 % reduziert und die Einnahmen der Betreiber um 20 % gesteigert werden.

Diese Lösungen verbessern auch die Durchsetzung und unterstützen nahtlose digitale Zahlungen und kontaktlosen Zugang.

4. Smart Parking als Teil des Smart City Grid

Smart Parking ist heute ein wichtiger Bestandteil des umfassenderen Smart City-Ökosystems. Parkdaten werden in städtische Mobilitätsplattformen und EV-Ladenetzwerke integriert, um den Verkehrsfluss zu steuern, den Energieverbrauch zu optimieren und die Nachhaltigkeit zu fördern.

5. Benutzererfahrung und Nachhaltigkeit

Mobile und cloudbasierte Apps bieten Autofahrern Echtzeit-Parkplatzsuche und Zahlungsoptionen.

Intelligente Parksysteme unterstützen auch umweltfreundliche Initiativen durch die Integration von EV-Ladeinfrastruktur.

Zusammenfassung: Im Jahr 2025 werden Smart Parking und Verkehrsanalyse dank KI und Computer Vision erhebliche Fortschritte machen. Diese Innovationen führen zu weniger Verkehr, geringeren Emissionen, höheren Einnahmen für Betreiber und einer grundlegenden Veränderung in der Art und Weise, wie Städte Mobilität und Stadtplanung verwalten. Nachträglich Links zu einigen der Quellen (Englisch)

-

Smart Parking 2025: Die 5 Innovationen, welche die urbane Mobilität verändern werden

-

2025 ANPR Guide – Wie Nummernschilderkennung moderne Abläufe revolutioniert

-

Global Smart Parking Systeme Markt Analyse 2025-2030: Wachstum

Weltweit führen Städte intelligente Park- und Verkehrsanalysesysteme ein. Hier sind einige Beispiele aus Ihrer Region und aus dem Ausland:

Beispiele in Europa und der Schweiz

-

Frauenfeld, Schweiz: Die Stadt führte zusammen mit dem Unternehmen Parquery AG ein Pilotprojekt für intelligentes Parken unter Verwendung von Bilderkennung durch. Daten zu verfügbaren Parkplätzen werden an eine App gesendet, um Autofahrern bei der Suche nach Parkplätzen zu helfen.

-

Kanton Zürich, Schweiz: Der Kanton veröffentlichte einen umfassenden Bericht über bewährte Verfahren für intelligentes Parken unter Verwendung von Bilderkennung, basierend auf der Fallstudie aus Frauenfeld. Dieser dient anderen Schweizer Städten als Leitfaden.

-

St. Gallen, Schweiz: Die Stadt startete ein Pilotprojekt für intelligentes Parken auf Basis eines LoRaWAN-Funknetzes (Long Range Wide Area Network) zur Verbindung von Parksensoren.

-

Santander, Spanien: Santander gilt als Pionier im Bereich Smart-City-Technologie. Seit 2009 wurden in der ganzen Stadt über 20.000 Sensoren installiert, um die Parkplatzbelegung zu überwachen und den Verkehr entsprechend umzuleiten.

-

Barcelona, Spanien: Die Stadt ist bekannt für ihre intelligente Verkehrssteuerung, die Staus reduziert und die Fahrzeiten verkürzt.

-

London, England: London nutzt bereits in einigen Bereichen intelligente Parklösungen mit Sensoren und verfügt über ein fahrerloses Nahverkehrssystem (Heathrow Pods) am Flughafen.

Internationale Beispiele

-

Miami-Dade, USA: Die Stadt nutzt ein „Advanced Traffic Management System (ATMS)”, das auf mobilen Routern basiert, um Staus und Verzögerungen zu reduzieren.

-

Songdo, Südkorea: In diesem Geschäftsviertel werden 300 interaktive Sicherheitskameras über eine Leitstelle überwacht.

-

Singapur: Die Stadt ist bekannt für ihre fortschrittlichen Nahverkehrssysteme, die stark auf Sensoren und Datenanalyse setzen.

Blogbeitrag vom 4. August 2025

Ihre Welt, smarter: Wie QR-Codes und Computer-Vision das Leben einfacher machen

von Kevin Lancashire (Link zum Original-Text auf Englisch)

Sie haben wahrscheinlich schon einmal einen QR-Code gescannt – vielleicht für eine Speisekarte im Restaurant, eine Konzertkarte oder um schnell eine Website zu besuchen. Diese praktischen Quadrate gibt es schon seit einiger Zeit und sie machen es einfach, Ihre physische Welt mit digitalen Informationen zu verbinden. Aber was wäre, wenn sie noch mehr könnten?

Dank einer leistungsstarken Partnerschaft mit Computer Vision – der Technologie, die Computern hilft, Bilder zu „sehen” und zu verstehen – bieten QR-Codes Ihnen nun ein neues Maß an Komfort, Transparenz und personalisierten Erlebnissen.

Mehr als nur ein Scan: Was haben Sie davon?

Stellen Sie sich Folgendes vor:

Intelligenter Einkaufen, weniger Aufwand

-

Sofortige Produktdetails: Scannen Sie einen QR-Code auf einem Produkt und erhalten Sie sofort umfassende Informationen zu dessen Herstellungsdetails, Herkunft oder Nachhaltigkeitsmaßnahmen. Kein Rätselraten mehr – Sie erhalten die Fakten, die Sie interessieren, direkt auf Ihrem Smartphone.

- Personalisierte Angebote: Der gleiche Scan kann Sonderangebote auslösen, die speziell auf Sie zugeschnitten sind, basierend auf Ihren Vorlieben oder früheren Einkäufen.

-

Virtuelles Anprobieren: Sie möchten neue Kleidung oder Möbel kaufen? Scannen Sie einen Code und nutzen Sie Augmented Reality (AR), um Artikel virtuell „anzuprobieren“ oder zu sehen, wie Möbel in Ihrer Wohnung aussehen, bevor Sie sie kaufen. Das stärkt Ihr Vertrauen und kann sogar Rückgaben reduzieren.

-

Schnelleres Bezahlen: In einigen Geschäften sorgt Computer Vision für ein nahtloses, kassenloses Einkaufserlebnis, sodass Sie sich die gewünschten Artikel nehmen und gehen können, ohne in der Schlange stehen zu müssen.

Beispiellose Transparenz und Vertrauen

-

Sofortige Produktdetails: Scannen Sie einen QR-Code auf einem Produkt und erhalten Sie sofort umfassende Informationen zu dessen Herstellungsdetails, Herkunft oder Nachhaltigkeitsmaßnahmen. Kein Rätselraten mehr – Sie erhalten die Fakten, die Sie interessieren, direkt auf Ihrem Smartphone.

-

Personalisierte Angebote: Der gleiche Scan kann Sonderangebote auslösen, die speziell auf Sie zugeschnitten sind, basierend auf Ihren Vorlieben oder früheren Einkäufen.

-

Virtuelles Anprobieren: Sie möchten neue Kleidung oder Möbel kaufen? Scannen Sie einen Code und nutzen Sie Augmented Reality (AR), um Artikel virtuell „anzuprobieren“ oder zu sehen, wie Möbel in Ihrer Wohnung aussehen, bevor Sie sie kaufen. Das stärkt Ihr Vertrauen und kann sogar Rückgaben reduzieren.

-

Schnelleres Bezahlen: In einigen Geschäften sorgt Computer Vision für ein nahtloses, kassenloses Einkaufserlebnis, sodass Sie sich die gewünschten Artikel nehmen und gehen können, ohne in der Schlange stehen zu müssen.

Das Fazit für Sie

Die Kombination aus Computer Vision und QR-Codes bedeutet ein besser informiertes, bequemeres und personalisierteres Erlebnis in Ihrem Alltag. Sie erhalten mehr Kontrolle über die Informationen, die Sie erhalten, profitieren von reibungsloseren Interaktionen und können darauf vertrauen, dass die von Ihnen ausgewählten Produkte Ihren Werten entsprechen. Es geht darum, Ihre Welt smarter zu machen, einen Scan nach dem anderen.

Weitere Informationen:

1. Computer vision – Wikipedia

2. Computer Vision Tutorial – GeeksforGeeks

3. How Do QR Codes Work?QR Code Technical Basics

5. How to Monetize Data: 2025 Data Monetization Strategies – Qrvey

6. QR Code possible data types or standards – Stack Overflow

7. Digitaler Produktepass – Der Schlüssel zur Transparenz und Nachhaltigkeit in der EU

Blogbeitrag vom 25. Juli 2025

Ihre nächste Mahlzeit: Von KI gesehen und verstanden?

von Kevin Lancashire (Link zum Original-Text auf Englisch)

Die einfache Smartphone-Kamera, einst ein Werkzeug für Urlaubsfotos, verändert nun still und leise unser Verständnis unserer täglichen Ernährung. Jahrelang war das Aufzeichnen unserer Ernährung eine mühsame Angelegenheit, die oft mit Fehlern und Vergesslichkeit behaftet war. Doch eine neue Welle der Computer-Vision-Technologie beginnt nun, eine objektivere Sichtweise zu bieten.

Dieses sich entwickelnde Gebiet, in dem künstliche Intelligenz lernt, Lebensmittel zu „sehen” und zu interpretieren, verspricht, über die Subjektivität traditioneller Ernährungstagebücher hinauszugehen. Es entstehen Systeme, die Lebensmittel erkennen, Portionsgrößen schätzen und sogar den Nährstoffgehalt direkt aus einem Foto berechnen können. Anwendungen wie SnapCalorie zeigen, wie mobile Technologien nahezu in Echtzeit Einblicke in die Ernährung liefern können, wodurch Einzelpersonen potenziell in die Lage versetzt werden, mit weniger Aufwand fundiertere Entscheidungen zu treffen. Die Entwicklung umfassender Datensätze wie Nutrition5k erweist sich als entscheidend für das Training dieser hochentwickelten Modelle des maschinellen Lernens.

Der Weg zur breiten Akzeptanz ist jedoch nicht ohne Schwierigkeiten. Die Genauigkeit, insbesondere bei der Schätzung von Portionsgrößen, bleibt eine große Hürde; selbst geschulte Experten haben damit Schwierigkeiten. Angesichts der Notwendigkeit einer kontinuierlichen Bildaufnahme gibt es auch berechtigte Bedenken hinsichtlich des Datenschutzes. Darüber hinaus hängt die Wirksamkeit dieser Systeme stark von der Vielfalt und Qualität ihrer Trainingsdaten ab, und eine Verzerrung zugunsten bestimmter Lebensmittelarten könnte zu weniger zuverlässigen Ergebnissen für andere führen. Laufende Forschung ist unerlässlich, um diese Algorithmen zu verfeinern und ihre Zuverlässigkeit unter den vielfältigen Bedingungen des Alltags sicherzustellen.

Die Technologie befindet sich zwar noch in der Entwicklung, doch die potenziellen Vorteile für die öffentliche Gesundheit und die individuelle Ernährungssteuerung liegen auf der Hand. Dieser Übergang von manuellen, oft ungenauen Methoden zu einem stärker datengestützten Ansatz könnte ein wertvolles Instrument zur Förderung gesünderer Ernährungsgewohnheiten in verschiedenen Bevölkerungsgruppen sein. Der Weg dorthin erfordert kontinuierliche Innovation und eine sorgfältige Abwägung sowohl der technischen als auch der ethischen Dimensionen, um die Wirkung wirklich zu maximieren.

Hier sind die Quellen, auf denen der Newsletter basiert:

Computer Vision for Food Quality Assessment: Advances and Challenges

SnapCalorie AI Calorie Counter (Google Play Store)

Blogbeitrag vom 18. Juli 2025

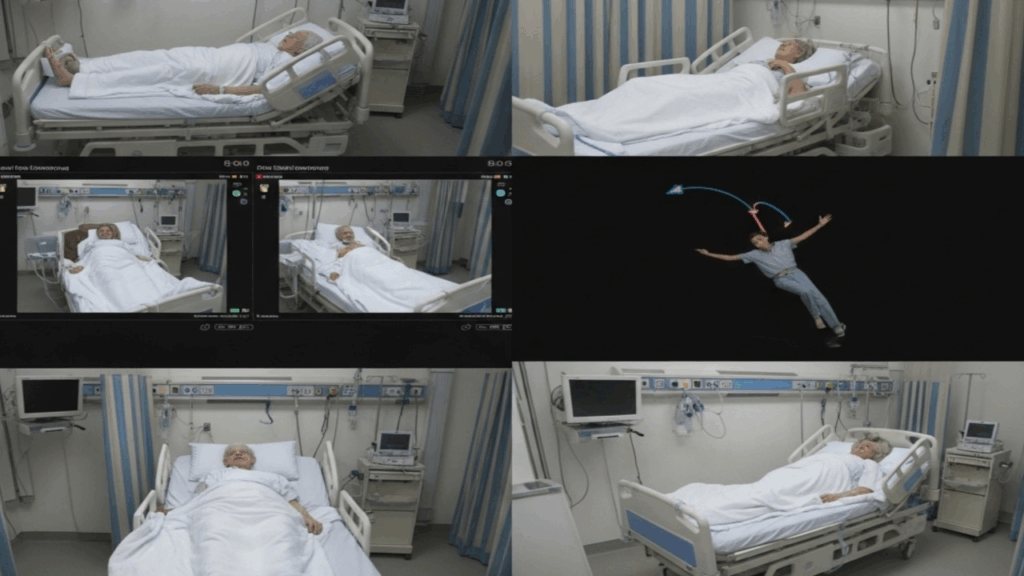

Computer Vision und KI: Revolutionierung der Patientenüberwachung

von Kevin Lancashire (Link zum Original-Text auf Englisch)

Computer-Vision-Systeme, die häufig RGB-Videos nutzen, die von in Patientenzimmern installierten Kameras aufgenommen werden, liefern zunehmend Echtzeit-Einblicke in das Verhalten, die Bewegungen und Interaktionen von Patienten. Diese hochentwickelten Systeme verwenden fortschrittliche Modelle, beispielsweise auf Basis der YOLOv4-Architektur, für eine präzise Objekterkennung und identifizieren wichtige Elemente wie „Person“, „Bett“ und „Stuhl“ innerhalb der überwachten Umgebung. Die Bewegungsschätzung erfolgt mithilfe von Algorithmen wie dem dichten optischen Fluss nach Gunnar-Farneback, der die horizontale und vertikale Verschiebung für jedes Pixel zwischen aufeinanderfolgenden Bildern berechnet und so einen Indikator für die Aktivitätsintensität liefert.

Durch die Analyse dieser detaillierten Datenströme kann die KI übergeordnete Metriken verfolgen, wie z. B. den Status „Patient allein“ – der die Abwesenheit von Pflegepersonal in einer definierten Nähe zum Patienten anzeigt. Diese Metrik ist ein wichtiger Indikator für die Bewertung des Sturzrisikos und die Identifizierung unbeaufsichtigter Bewegungen und geht über die einfache Erkennung hinaus bis hin zur kontinuierlichen Analyse der Aktivitätsintensität und Trends im Zeitverlauf. Die Fähigkeit dieser Systeme, solche Indikatoren zuverlässig und mit nachgewiesener Genauigkeit zu verfolgen, erhöht die Sicherheit erheblich, da sie die Erkennung von Risiken (z. B. Patienten, die unbeaufsichtigt ihr Bett verlassen) ermöglicht, die bei regelmäßigen Untersuchungen möglicherweise übersehen werden.

Computer-Vision-Systeme, die häufig RGB-Videos nutzen, die von in Patientenzimmern installierten Kameras aufgenommen werden, liefern zunehmend Echtzeit-Einblicke in das Verhalten, die Bewegungen und Interaktionen von Patienten. Diese hochentwickelten Systeme verwenden fortschrittliche Modelle, beispielsweise auf Basis der YOLOv4-Architektur, für eine präzise Objekterkennung und identifizieren wichtige Elemente wie „Person“, „Bett“ und „Stuhl“ innerhalb der überwachten Umgebung. Die Bewegungsschätzung erfolgt mithilfe von Algorithmen wie dem dichten optischen Fluss nach Gunnar-Farneback, der die horizontale und vertikale Verschiebung für jedes Pixel zwischen aufeinanderfolgenden Bildern berechnet und so einen Indikator für die Aktivitätsintensität liefert.

Durch die Analyse dieser detaillierten Datenströme kann die KI übergeordnete Metriken verfolgen, wie z. B. den Status „Patient allein“ – der die Abwesenheit von Pflegepersonal in einer definierten Nähe zum Patienten anzeigt. Diese Metrik ist ein wichtiger Indikator für die Bewertung des Sturzrisikos und die Identifizierung unbeaufsichtigter Bewegungen und geht über die einfache Erkennung hinaus bis hin zur kontinuierlichen Analyse der Aktivitätsintensität und Trends im Zeitverlauf. Die Fähigkeit dieser Systeme, solche Indikatoren zuverlässig und mit nachgewiesener Genauigkeit zu verfolgen, erhöht die Sicherheit erheblich, da sie die Erkennung von Risiken (z. B. Patienten, die unbeaufsichtigt ihr Bett verlassen) ermöglicht, die bei regelmäßigen Untersuchungen möglicherweise übersehen werden.

Fortschrittliche Anwendungen in der Fernüberwachung von Patienten

Computer Vision revolutioniert die Fernüberwachung von Patienten (Remote Patient Monitoring, RPM), indem sie fortschrittliche, unauffällige Überwachungsfunktionen direkt in die Patientenumgebung bringt und das Gesundheitswesen zu einem proaktiveren und umfassenderen Ansatz führt.

-

Bewegungs- und Haltungsanalyse: Computer-Vision-Systeme, die häufig RGB-Videos von Kameras verwenden, analysieren das Verhalten, die Bewegungen und die Interaktionen von Patienten in Echtzeit. Sie können kritische Ereignisse wie Stürze oder unbeaufsichtigte Bewegungen erkennen, indem sie Objekte wie „Person“, „Bett“ und „Stuhl“ identifizieren und eine Bewegungsschätzung durchführen. Diese kontinuierliche Analyse der Aktivitätsintensität und der Trends im Zeitverlauf erhöht die Patientensicherheit erheblich, indem sie Risiken aufzeigt, die bei regelmäßigen Kontrollen möglicherweise übersehen werden. Für einen Gartenliebhaber wie Sie, der gerne schneidet und pflegt, könnte dies mit der kontinuierlichen Überwachung der Gesundheit Ihrer Pflanzen auf frühe Anzeichen von Stress vergleichbar sein, anstatt sie nur gelegentlich zu überprüfen.

-

Berührungslose Überwachung der Vitalfunktionen: Über die Bewegung hinaus kann Computer Vision, insbesondere durch Remote-Photoplethysmographie (rPPG), winzige Veränderungen der Gesichtsfarbe aufgrund des Blutflusses erkennen, um Pulsfrequenz und Blutdruck zu bestimmen, und das alles ohne physischen Kontakt. Diese Methode erhöht den Komfort für den Patienten und verringert das Infektionsrisiko, wodurch sie sich ideal für gefährdete Bevölkerungsgruppen eignet.

-

Analyse von Gesichtsausdrücken zur Erkennung von Stress: Mithilfe von KI und Deep Learning kann Computer Vision subtile Gesichtsausdrücke analysieren, um Anzeichen von Schmerzen, Stress oder anderen emotionalen Zuständen zu erkennen, selbst wenn Patienten nicht verbal kommunizieren können. Dies ist besonders wertvoll für Säuglinge, schwerkranke Menschen oder Menschen mit kognitiven Beeinträchtigungen, da es eine objektive Beurteilung subjektiver Zustände ermöglicht.

-

Multimodale KI für ganzheitliche Einblicke: Die wahre Leistungsfähigkeit zeigt sich, wenn Computer-Vision-Daten durch multimodale KI mit anderen Quellen wie Wearables und Umgebungssensoren integriert werden. Dies ermöglicht einen umfassenderen Überblick über die Gesundheit des Patienten und ermöglicht hochpräzise Analysen und proaktive Interventionen, bevor sich eine Krise manifestiert.

Durch kontinuierliche, unauffällige Überwachung und tiefe Einblicke in physiologische und Verhaltensmuster macht Computer Vision RPM effektiver, erhöht die Patientensicherheit und trägt zu einer personalisierteren und zugänglicheren Gesundheitslandschaft bei.

Quellen:

- Remote Patient Monitoring: The Complete Guide – Health Recovery Solutions, accessed July 18, 2025, https://www.healthrecoverysolutions.com/remote-patient-monitoring

- What is Remote Patient Monitoring and Why is it Transforming Healthcare? – Medixine, accessed July 18, 2025, https://medixine.com/what-is-remote-patient-monitoring/

- Telehealth and Remote Patient Monitoring Innovations in Nursing Practice: State of the Science | OJIN, accessed July 18, 2025, https://ojin.nursingworld.org/table-of-contents/volume-28-2023/number-2-may-2023/special-topic-nursing-now/telehealth-and-remote-patient-monitoring/

- Continuous Versus Intermittent Vital Signs Monitoring Using a Wearable, Wireless Patch in Patients Admitted to Surgical Wards – PubMed Central, accessed July 18, 2025, https://pmc.ncbi.nlm.nih.gov/articles/PMC6305881/

- Continuous Patient Monitoring in Healthcare: A Comprehensive Review of Opportunities, Challenges, and Future Directions – ResearchGate, accessed July 18, 2025, https://www.researchgate.net/publication/393564686_Continuous_Patient_Monitoring_in_Healthcare_A_Comprehensive_Review_of_Opportunities_Challenges_and_Future_Directions

- What Are The Benefits Of Remote Patient Monitoring For Hospitals? – Consensus Academic Search Engine, accessed July 18, 2025, https://consensus.app/questions/what-benefits-remote-patient-monitoring-hospitals/

- Shaping the Future of Healthcare: AI Patient Monitoring – Ambula EMR system, accessed July 18, 2025, https://www.ambula.io/shaping-the-future-of-healthcare-ai-patient-monitoring/

- Remote Patient Monitoring Is Making Healthcare More Accessible Than Ever In The Digital Age – Blog, accessed July 18, 2025, https://blog.pqegroup.com/gxp-compliance/remote-patient-monitoring-is-making-healthcare-more-accessible-than-ever-in-the-digital-age

- Key Fundamentals and Examples of Sensors for Human Health: Wearable, Non-Continuous, and Non-Contact Monitoring Devices – MDPI, accessed July 18, 2025, https://www.mdpi.com/1424-8220/25/2/556

- 5 Benefits of Remote Patient Monitoring – KORE Wireless, accessed July 18, 2025, https://www.korewireless.com/blog/5-benefits-of-remote-patient-monitoring/

- Remote Vital Sensing in Clinical Veterinary Medicine: A … – MDPI, accessed July 18, 2025, https://www.mdpi.com/2076-2615/15/7/1033

Blogbeitrag vom 10. Juli 2025

Ihre Welt durch die KI-Linse: Was Smartphone Vision-Daten für Sie bedeuten

von Kevin Lancashire (Link zum Original-Text auf Englisch) Dieser Text wurde leicht redigiert

Ihr Smartphone, ausgestattet mit KI, verarbeitet mithilfe seiner Kamera und Sensoren ständig die Welt um Sie herum. Dabei geht es nicht nur um coole Funktionen, sondern um eine grundlegende Veränderung Ihrer Interaktionen, Ihrer Privatsphäre und sogar Ihrer Wahrnehmung.

Für Ihren Alltag und Ihren Komfort

-

Intelligentere Interaktionen: Ihr Smartphone kann jetzt beispielsweise Objekte, die Sie sehen, sofort identifizieren – eine Pflanze im Garten (auch wenn Sie sich nicht an ihren genauen Namen erinnern bekommen Sie ihn vom Telefon!), ein Restaurantschild oder Text auf einem Dokument. Es kann dann sofortige Aktionen anbieten, wie z. B. Details nachschlagen, Text übersetzen oder sogar direkt aus dem, was es „sieht“, einen Kalendertermin erstellen.

-

Mehr Kreativität: Mit der KI-gestützten Funktion „Clean Up” in Fotos können Sie unerwünschte Elemente nahtlos aus Ihren Bildern entfernen. Mit den neuen Funktionen „Genmoji” und „Image Wand” können Sie personalisierte visuelle Inhalte erstellen, indem Sie diese einfach beschreiben, oder eine grobe Skizze in ein ausgefeiltes Bild verwandeln.

-

Optimierte Kommunikation: Ihr Smartphone kann beispielsweise lange E-Mails oder Audio-Transkriptionen zusammenfassen und Ihnen so helfen, den Überblick zu behalten. Es schlägt intelligente Antworten in Nachrichten vor und spart Ihnen Zeit.

-

Personalisierte Gesundheit: Ihr Smartphone wird zunehmend zu einem persönlichen Gesundheitsmonitor, der mithilfe seiner Kamera und anderer Sensoren Vitalparameter oder Schlafmuster verfolgt. Das bedeutet personalisiertere Wellness-Empfehlungen und eine Verlagerung hin zur Vorsorge für Sie.

-

Intuitives Einkaufen: Mit der „visuellen Suche” können Sie Ihre Kamera auf einen Artikel in einem Geschäft richten und sofort ähnliche Produkte online finden. Dies verändert die Art und Weise, wie Sie Dinge entdecken und kaufen, und macht das Einkaufen unmittelbarer.

Für Ihre Privatsphäre & Identität

-

Das „Datenschutzparadoxon”: Während Apple zur Wahrung Ihrer Privatsphäre Wert auf die Verarbeitung auf dem Gerät legt (was bedeutet, dass die Rohdaten oft auf Ihrem Smartphone verbleiben), bedeutet die schiere Menge der von Ihnen generierten visuellen Daten, dass Ihr Gerät ständig Ihre Welt interpretiert. Auch wenn einzelne Daten nicht immer weitergegeben werden, können aus den aggregierten Mustern von Millionen von Nutzern dennoch Verhaltensweisen oder Präferenzen abgeleitet werden. Das bedeutet, dass Sie sich bewusst sein müssen, dass selbst die lokale Verarbeitung zu einem größeren, komplexen Datenökosystem beitragen kann.

-

Algorithmische Verzerrung in Ihrem Feed: Die von Millionen von Nutzern, darunter auch Ihnen, gesammelten visuellen Daten trainieren die KI. Wenn diese Daten gesellschaftliche Verzerrungen enthalten (z. B. bei der Gesichtserkennung, wie wir bei höheren Fehlerquoten für bestimmte Bevölkerungsgruppen gesehen haben), können diese Verzerrungen verstärkt werden und die Interaktionen der KI mit Ihnen beeinflussen. Dies kann sich auf alles auswirken, von gezielten Werbeanzeigen bis hin zur Art und Weise, wie Sie in Sicherheitssystemen identifiziert werden.

-

Vermittelte Realität und Selbstwahrnehmung: Die ständige Verwendung von visuellen KI-Filtern in sozialen Medien kann zu unrealistischen Schönheitsidealen führen. Wenn Sie sich selbst oder andere durch diese Filter sehen, kann dies Ihre Selbstwahrnehmung verzerren, den sozialen Vergleich verstärken und eine Diskrepanz zwischen Ihrem realen und Ihrem digitalen Selbst schaffen, was möglicherweise Ihre Authentizität untergräbt.

-

Vertrauen in das, was Sie sehen: Der Aufstieg von „Deepfakes“ – hyperrealistischen, von KI generierten Videos – macht es Ihnen schwerer, online zu unterscheiden, was echt und was gefälscht ist. Dies stellt Ihre Fähigkeit, visuellen Informationen zu vertrauen, auf die Probe und kann zu einer „postfaktischen“ Umgebung beitragen, in der es immer schwieriger wird, Fakten zu erkennen.

Für Ihre Fähigkeiten und Ihre Zukunft

-

Sich wandelnde Anforderungen an Ihre Fähigkeiten: Da KI sowohl einfache als auch komplexe visuelle Aufgaben automatisiert, müssen Sie Ihre Fähigkeiten anpassen. Der wirtschaftliche Wert wird zunehmend davon abhängen, wie Sie mit KI zusammenarbeiten und spezialisierte KI-Aufsichtsrollen entwickeln. Das bedeutet, dass kontinuierliches Lernen nicht nur ein Bonus ist, sondern für Ihre berufliche Relevanz unerlässlich ist.

Im Wesentlichen bieten die visuellen Funktionen Ihres Smartphones unglaublichen Komfort und neue Möglichkeiten, mit der Welt zu interagieren, aber sie erfordern auch Ihr achtsames Engagement und ein ausgeprägtes Bewusstsein dafür, wie Ihre Daten verwendet werden und wie KI Ihre Wahrnehmung und Privatsphäre beeinflussen kann.

Quellen

How AI is Shaping the Future of Smartphones | The AI Journal

10 Computer Vision Applications for 2025 | DigitalOcean

Blogbeitrag vom 6. Juli 2025

Das algorithmische Auge auf dem Wohlergehen

von Kevin Lancashire (Link zum Original-Text auf Englisch)

Computer Vision, einst weitgehend auf die akademische Forschung beschränkt, liefert heute greifbare Vorteile in verschiedenen Gesundheitsanwendungen. Von der Früherkennung von Krankheiten über die Unterstützung der Rehabilitation bis hin zur Optimierung von Fitnessprogrammen bietet diese Technologie Echtzeitüberwachung und personalisiertes Feedback. Sie stellt einen erheblichen Fortschritt dafür dar, Menschen ihre Gesundheit verwalten und wie medizinisches Fachpersonal Gesundheitsleistungen erbringt.

Die Verbreitung von Wearable-Technologie – Smartwatches und Fitness-Tracker, deren Marktvolumen mittlerweile auf unglaubliche 100 Milliarden Dollar geschätzt wird – hat diese Entwicklung massgeblich beschleunigt. Diese allgegenwärtigen Geräte sammeln riesige Mengen an biometrischen Daten, von der Herzfrequenz bis zum Aktivitätsniveau, die dann durch fortschrittliche Algorithmen in anwendbare Erkenntnisse umgewandelt werden. Es ist das digitale Äquivalent zu einem persönlichen Gesundheitsberater, der einem ständig zur Seite steht.

Diese transformative Kraft bringt jedoch auch gewisse Komplexitäten mit sich. Als Liberaler bin ich der festen Überzeugung, dass ethische Überlegungen zum Datenschutz und zu algorithmischen Verzerrungen von grösster Bedeutung sind. Die schiere Menge an sensiblen persönlichen Gesundheitsdaten, die verarbeitet werden, erfordert strenge Aufmerksamkeit für Sicherheit und transparente Datenpraktiken, um die Einhaltung von Vorschriften wie der DSGVO zu gewährleisten. Debatten über die Genauigkeit von Daten und das Potenzial für algorithmische Diskriminierung unterstreichen die Notwendigkeit robuster ethischer Rahmenbedingungen für die Entwicklung von KI.

Eine kurze Geschichte von Sehvermögen und Bytes

Die Entwicklung der Computervision im Gesundheits- und Fitnessbereich reicht bis in die Anfänge der Kybernetik und Robotik zurück. Was als theoretisches Konzept begann, hat sich durch Durchbrüche im Bereich des Deep Learning und die Verfügbarkeit riesiger Datensätze zu praktischen Lösungen für reale Probleme entwickelt. Der Fortschritt von der einfachen Bildverarbeitung hin zu ausgefeilter Objekterkennung und Bewegungserfassung bedeutet eine tiefgreifende Veränderung in der Art und Weise, wie Maschinen visuelle Informationen interpretieren.

Diese Entwicklung hat tiefgreifende Auswirkungen auf das Gesundheitswesen gehabt, die Diagnosegenauigkeit verbessert und sogar minimalinvasive chirurgische Eingriffe erleichtert. Im Fitnessbereich haben diese Fortschritte den Zugang zu Gesundheitsdienstleistungen demokratisiert und innovative Ansätze zur Fortschrittsverfolgung und frühzeitigen Risikoerkennung ermöglicht. Dies signalisiert einen breiteren Trend zur Nutzung künstlicher Intelligenz, um die Gesundheitsergebnisse zu verbessern und das Engagement der Nutzer für Wellness-Aktivitäten zu vertiefen.

Die technologischen Grundlagen

Im Kern basiert Computer Vision auf einer Reihe ausgefeilter Technologien:

-

Bildverarbeitung: Techniken zur Verfeinerung von visuellen Rohdaten, einschliesslich Rauschunterdrückung und Segmentierung, sind entscheidend für die Isolierung relevanter Informationen – sei es eine krebsartige Läsion oder eine Fehlstellung eines Gelenks.

-

Datenerfassung: Die anfängliche Erfassung visueller Informationen stützt sich auf fortschrittliche medizinische Bildgebungsgeräte wie MRT- und CT-Scanner sowie auf die immer leistungsfähigeren Kameras, die in Unterhaltungselektronikgeräten eingebaut sind.

-

Merkmalsextraktion: Dieser wichtige Schritt umfasst die Identifizierung und Quantifizierung hervorstechender Merkmale in Bildern, wobei visuelle Muster in eine mathematische Sprache umgewandelt werden, die von Algorithmen für maschinelles Lernen interpretiert werden kann.

-

Algorithmen für maschinelles Lernen: Dies sind die Analyse-Engines, die Muster klassifizieren und erkennen. Herkömmliche Methoden wie Support Vector Machines sind nach wie vor relevant, aber der eigentliche Paradigmenwechsel kam mit Convolutional Neural Networks (CNNs). Diese Deep-Learning-Architekturen zeichnen sich durch hervorragende Bilderkennung aus und zeigen bemerkenswerte Effizienz bei Aufgaben, die von der medizinischen Diagnose bis zur Haltungsanalyse reichen.

Da sich diese Technologien rasant weiterentwickeln, wird die Notwendigkeit robuster regulatorischer Rahmenbedingungen für Datenschutz, Algorithmentransparenz und Genauigkeitsstandards immer dringlicher.

Anwendungen und ihre Auswirkungen

Die praktischen Anwendungsmöglichkeiten von Computer Vision im Gesundheits- und Fitnessbereich sind vielfältig:

-

Wearables: Diese allgegenwärtigen Geräte liefern Echtzeitdaten zum physiologischen Zustand des Nutzers und lassen sich nahtlos in den Alltag integrieren.

-

KI-gestützte Personalisierung: KI-Algorithmen können Gesundheitsdaten synthetisieren, um massgeschneiderte Trainingsprogramme zu erstellen, die Aktivitätsprotokollierung zu automatisieren und eine Leistungsanalyse in Echtzeit anzubieten. Dieser spielerische Ansatz verbessert die Einhaltung und Wirksamkeit.

-

Online-Coaching: Virtuelle Plattformen nutzen Daten von Wearables, um Nutzer mit Remote-Trainern zu verbinden und so einen personalisierteren und datengestützten Ansatz für die Fitnessberatung zu fördern.

-

Bewegungsanalyse: Detaillierte Bewertungen der Körperhaltung und der Trainingsform sind für die Rehabilitation von unschätzbarem Wert und ermöglichen es Therapeuten, massgeschneiderte Rehabilitationsprogramme zu verschreiben.

-

Fernüberwachung: Über die Fitness hinaus kann Computer Vision auf nicht-invasive Weise Vitalparameter und subtile physiologische Veränderungen verfolgen und so eine kontinuierliche Patientenüberwachung bei chronischen Erkrankungen ermöglichen.

-

Diagnostische Präzision: Fortschrittliche Algorithmen reduzieren das Potenzial für menschliche Fehler bei Gesundheitsbewertungen und führen zu zuverlässigeren Diagnosen.

Die Zukunft gestalten

Trotz des transformativen Potenzials ist der Weg in die Zukunft nicht ohne Hindernisse:

-

Datenschutz: Die Sensibilität von Gesundheitsdaten erfordert strenge Protokolle, um Verstösse und Missbrauch zu verhindern.

-

Algorithmische Verzerrung: Nicht repräsentative Trainingsdaten können zu diskriminierenden Ergebnissen führen, was die Notwendigkeit einer ethischen KI-Entwicklung und einer strengen Validierung unterstreicht.

-

Vertrauen und Akzeptanz: Das Vertrauen der Öffentlichkeit in KI-gestützte Gesundheitslösungen ist für eine breite Akzeptanz von entscheidender Bedeutung und erfordert Transparenz und einen klaren Nachweis der Vorteile.

-